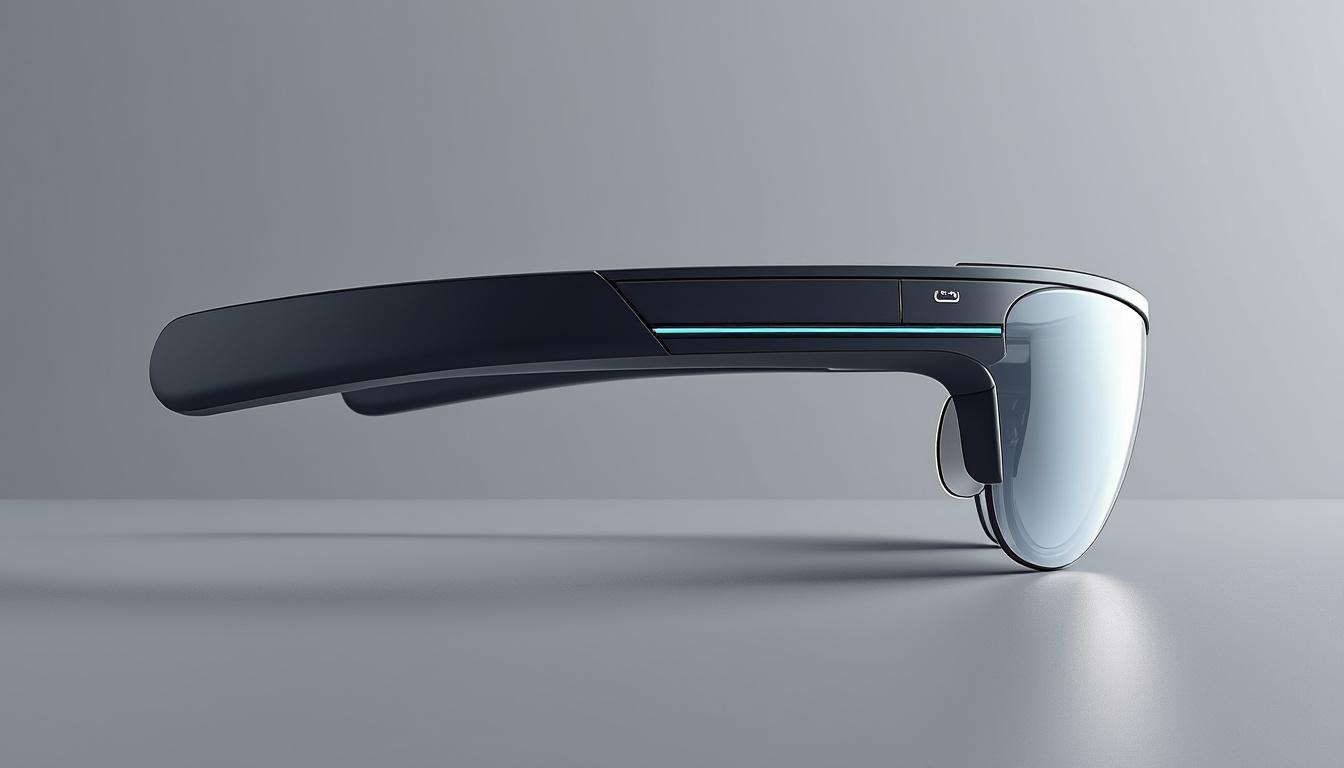

Apple et la disponibilité des premiers composants de ses lunettes connectées : un tournant technologique

Le secteur des lunettes connectées s’anime sous l’impulsion des géants de la tech. Si Meta et d’autres acteurs ont largement investi cette niche, Apple paraît prêt à s’imposer dans ce domaine, avec ses propres lunettes intelligentes. En 2025, des informations indiquent que les premiers composants électroniques de ces lunettes sont désormais accessibles, signe que le projet entre dans une phase de concrétisation plus avancée.

Apple, qui a déjà posé les bases de son savoir-faire en technologie portable avec des produits comme l’Apple Watch et les AirPods, semble armé pour offrir une expérience de réalité augmentée plus fluide et intégrée que jamais. Ce n’est pas uniquement une question de placer des composants dans une monture, mais bien de maîtriser la partie logicielle, matérielle, et surtout l’interaction entre l’utilisateur et son environnement via cette technologie.

Ces premières composants disponibles sont cruciaux car ils posent les fondations du design optique ainsi que des accessoires intelligents qui viendront entourer ce nouvel appareil. Leur disponibilité marque une étape dans le développement d’Apple Glass, témoignant des progrès réalisés en miniaturisation des capteurs, en autonomie énergétique, et en performances diverses.

- Composants électroniques ultra-miniaturisés prêts à intégrer la monture

- Technologie wearable déjà éprouvée sur d’autres produits Apple et adaptée aux lunettes

- Début des fabrications pour tests industriels plus poussés

- Des innovations matérielles impliquant des capteurs, caméras et haut-parleurs invisibles

Cette étape technique est aussi le reflet des ambitions d’Apple sur le terrain très concurrentiel des wearables à réalité augmentée. La firme entend non seulement rivaliser mais aussi redéfinir les usages associés aux lunettes connectées en proposant un produit abouti respectant la philosophie de simplicité et d’intégration poussée propre à son écosystème.

Les défis techniques liés à l’intégration des composants dans les lunettes Apple Glass

Concevoir des lunettes connectées, c’est composer avec une foule de contraintes techniques qu’Apple explore actuellement. La disponibilité des premiers composants électroniques ne signifie pas que le chemin est dégagé : la miniaturisation nécessaire doit être extrême, car chaque élément doit tenir dans une monture fine et légère, sans altérer le confort ni le style.

Au-delà de l’aspect esthétique, c’est la qualité du design optique qui sera déterminante. L’intégration de capteurs, caméras haute définition, microphones et haut-parleurs doit être pensée pour assurer une excellente immersion en réalité augmentée, garder l’autonomie, mais aussi garantir une interface naturelle et efficace sans écran encombrant.

Apple travaille ainsi à rendre possible :

- La diffusion sonore via des haut-parleurs à conduction osseuse ou des dispositifs audio ouverts, pour une écoute discrète

- L’implantation de caméras miniatures capables de filmer en 3D spatiale et en haute résolution, reprenant l’expertise acquise sur les iPhones et le Vision Pro

- Des capteurs de mouvement et gestes qui interagiront de manière fluide avec les commandes vocales et tactiles

- Une autonomie optimisée grâce à des composants à faible consommation et une gestion avancée de l’énergie

La complexité réside notamment dans l’équilibre entre l’intégration dense des composants et la dissipation thermique. Le tout dans un poids et un volume parfaitement maîtrisés, indispensable pour que le porteur oublie qu’il tient des lunettes high-tech sur le nez.

Ce point technique est au cœur des contraintes de production et explique des reports ou ajustements dans le calendrier. Apple n’a pas seulement besoin d’un produit fonctionnel, mais d’une innovation matérielle qui réponde aux exigences des utilisateurs Apple, toujours attachés à la finesse et à l’esthétique.

L’expertise audio et gestuelle d’Apple au service des lunettes intelligentes

Les premières composantes ne se limitent pas à la simple électronique. Apple puise dans ses succès passés pour développer des fonctions audio avancées, adaptées à la réalité augmentée. Depuis les débuts des AirPods, la firme a exploré la spatialisation sonore 3D, la traduction en temps réel et même les aides auditives. Toutes ces fonctions sont des briques essentielles pour ses lunettes connectées.

La capacité des AirPods à filtrer les bruits ambiants, à détecter la fréquence cardiaque via certains capteurs et à réagir à l’intensité des mouvements de tête ou des gestes préfigurent un véritable compagnon portable pour la tête. Intégrer ces fonctionnalités dans des lunettes représente une avancée logique mais aussi technique, car l’espace et l’énergie disponibles sont limités.

Sur le plan gestuel, l’Apple Watch offre déjà plusieurs commandes par mouvements du poignet comme la double tape, permettant de répondre rapidement à un message. Ce savoir-faire ouvre la voie à des interactions sans contact avec les lunettes, par des micro-gestes ou des détections musculaires fines, à la manière du Neural Band de Meta, mais intégrées nativement au système d’exploitation.

- Fonctionnalités audio : traduction, spatialisation 3D, contrôle gestuel vocal

- Interopérabilité avec l’Apple Watch pour gestion des usages et notifications

- Commandes par gestes simples et intuitifs, optimisées pour usage mobile

- Possibilité d’intégrer un système de reconnaissance musculaire avancé pour un pilotage précis

Cette synergie entre technologies portables d’Apple crée un univers cohérent où chaque accessoire intelligent enrichit l’expérience utilisateur. Les lunettes connectées ne sont donc pas juste un gadget, mais un nouveau point d’entrée connecté, conçu pour fonctionner en harmonie avec un écosystème déjà mature et apprécié.

Réalité augmentée et intelligence artificielle : le cœur du projet Apple Glass

La réalité augmentée (AR) est la promesse technologique derrière les lunettes connectées. Apple mise ici sur une intégration sophistiquée d’une intelligence artificielle avancée qui va bien au-delà de l’affichage d’informations sur un écran. Les composants déjà disponibles servent non seulement à capter l’environnement et les gestes, mais aussi à traiter localement les données pour un rendu fluide et réactif.

À l’instar de ses progrès en intelligence visuelle sur iPhone, Apple vise à enrichir l’expérience visuelle avec des fonctions de reconnaissance contextuelle et d’aide augmentée en temps réel. Cela pourrait déboucher sur des usages variés :

- Navigation assistée, guidage pas à pas directement dans le champ de vision

- Informations enrichies sur les lieux, objets, ou personnes rencontrés

- Applications en santé avec suivi des comportements ou alertes personnalisées

- Captation vidéo 3D pour des souvenirs immersifs exploitables sur d’autres appareils

L’intelligence artificielle embarquée devrait également prendre en charge la reconnaissance vocale naturelle et la compréhension des commandes, pour renforcer l’interactivité avec Siri. Dans un monde où la réactivité est reine, ces lunettes permettraient un usage mains libres n’ayant rien à envier à un smartphone.

L’enjeu est aussi de supporter une miniaturisation des composants indispensables au traitement de données complexes, sans sacrifier la rapidité ou la précision. Le design optique, combiné à ces capacités numériques, annonce la naissance d’un produit aussi élégant que performant, capable de s’imposer sur ce marché en pleine expansion.

La stratégie d’Apple pour l’arrivée de ses lunettes connectées et l’écosystème associé

Au-delà de l’innovation matérielle, la disponibilité des composants correspond aussi à une phase de préparation commerciale et logistique. Apple s’appuie sur une forte présence dans ses Apple Stores pour proposer un parcours client adapté à ce nouveau produit complexe.

Les lunettes intelligentes nécessitent en effet une phase de fitting personnalisée, notamment pour les utilisateurs qui porteront des verres correcteurs. Le choix d’un design léger et modulable, accompagné d’une offre de prescription optique, sera sans doute une clé du succès. Cette stratégie rappelle celle mise en place pour le Vision Pro et ses options optiques via un partenaire spécialisé, Zeiss.

- Distribution mondiale dans des points de vente premium avec support technique dédié

- Intégration profonde avec les iPhones et autres appareils Apple pour une interconnexion sans faille

- Promotion d’une nouvelle catégorie d’applications adaptées à la réalité augmentée

- Incitation des développeurs à envisager des usages innovants pour ces wearables

Ce nouveau produit pourrait non seulement rivaliser avec les lunettes connectées déjà présentes comme les Ray-Ban de Meta, mais aussi ouvrir une nouvelle ère dans les accessoires intelligents. En se concentrant sur la simplicité d’usage et une harmonie logicielle avec les systèmes existants, Apple vise à concrétiser une expérience véritablement intégrée.

Dans ce contexte, la disponibilité des composants électroniques n’est pas uniquement une bonne nouvelle pour la production. Elle annonce que le défi de la réalité augmentée se transforme en une ambition concrète, prête à prendre forme dans un avenir proche, potentiellement dès 2026. Ce qui implique pour les utilisateurs de rester attentifs aux prochaines annonces officielles concernant cette innovation.

Quels sont les principaux composants essentiels aux lunettes connectées d’Apple ?

Les lunettes intégreront des capteurs miniatures, des caméras en 3D spatiale, des haut-parleurs à conduction osseuse, des microphones, ainsi que des processeurs permettant la gestion locale de l’intelligence artificielle et de la réalité augmentée.

En quoi les lunettes d’Apple se différencient-elles des autres wearables du marché ?

Apple mise sur une intégration fine entre ses lunettes et son écosystème matériel et logiciel, notamment l’Apple Watch, les iPhones et Siri, créant une expérience fluide, intuitive et bénéficiant d’une intelligence artificielle avancée.

Comment Apple assure-t-il le confort et le design de ses lunettes intelligentes malgré la miniaturisation ?

La firme optimise la taille et la dissipation thermique des composants, tout en misant sur un design léger et élégant pour que les lunettes soient agréables à porter toute la journée, avec un design optique soigné.

Quelle place occupe la réalité augmentée dans le fonctionnement des Apple Glass ?

La réalité augmentée est au centre des fonctionnalités, offrant des informations contextuelles, des aides visuelles et des interactions en temps réel, le tout piloté par une intelligence artificielle embarquée qui analyse l’environnement et les gestes de l’utilisateur.

Comment pourront être essayées et personnalisées les lunettes connectées chez Apple ?

Apple prévoit un service de fitting personnalisé dans ses Apple Stores, avec la possibilité d’ajouter des prescriptions optiques, ainsi qu’un accompagnement technique pour assurer un ajustement et un usage optimal.